苹果春晚量大管饱!市场想听的,“AI,MR,脑机”一次拉满?

AI 250 2023-06-06在十多年来关注度最高的一次WWDC大会上,苹果也不出市场预料地以one more thing炸场,发布了其继Mac、iPhone、iPad、Watch之后的全新计算平台——混合现实头显Vision Pro。

从发布会现场演示和后续的媒体试用评价来看,作为首款完全在库克领导下开发的硬件终端,Vision Pro的确不负众望,集苹果十多年来积累的工业设计和工程学能力于一体,堪称“世界上最先进的消费电子设备”,也表现出了库克所期待的成为下一部iPhone的潜力。

不过,虽然Vision Pro在发布会上技惊四座,但隔夜美股苹果股价却最终小幅收跌。

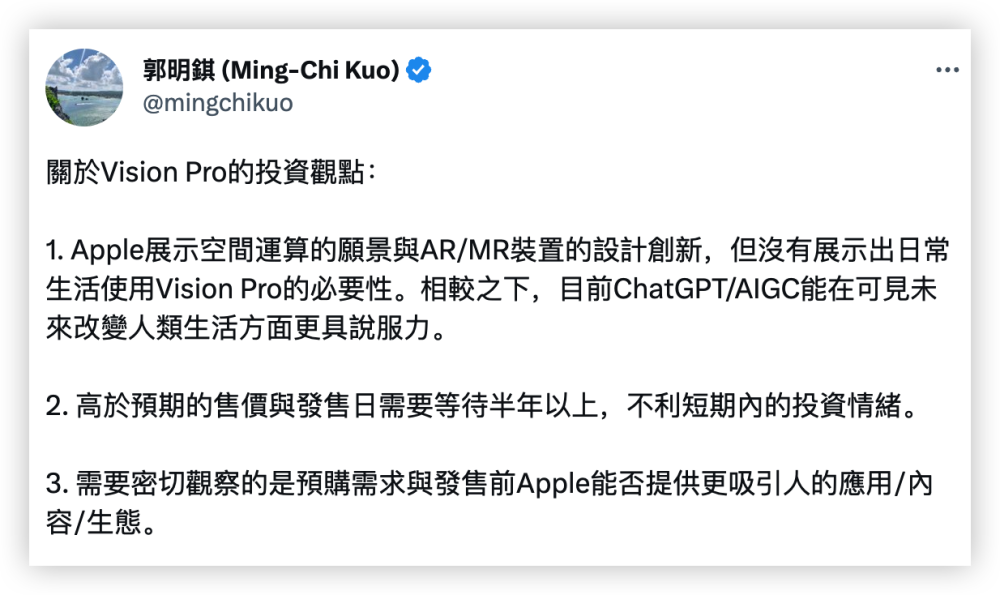

知名苹果分析师郭明錤认为,这主要是因为Vision Pro高昂的售价(高达3499美元,无缘大众市场)和遥远的发售日期(明年初美国市场首发)不利于短期投资情绪,且在演示环节中,没有明确展现出日常使用的必要性。

简单来说就是,虽然头显很酷很有科幻感,但缺乏类似手机、电脑那样的必要性。华尔街见闻在此前文章中提及,市场普遍质疑,消费者为什么要把在传统设备上能轻松完成的事情,转移到转移到一台价格高达3000美元、交互更麻烦的头显上?

尽管如此,苹果和库克,也是毋庸置疑的赢家。通过这场时长2个多小时、内容量大管饱的“科技春晚”,苹果不仅展现了其在软硬件研发上无可撼动的实力,在类似AI和脑机接口这样的新技术领域,也低调务实地小小秀了一下肌肉。

Vision Pro:什么元宇宙?别沾!

从发布会的演示来看,Vision Pro这款产品的确科幻感拉满。

在交互上,这款酷似滑雪镜的头显可以只靠眼睛、语音和手势来操作,没有笨重的外置手柄或此前市场猜测的智能手环。

戴上头显并通过Optic ID(虹膜ID)解锁后,就能体会到类似钢铁侠电影的场景:

眼睛所见的依然是你周围的世界,但整个Vision操作系统将会浮现在你眼前,包括苹果生态中的几十万个App,以及微软office办公软件、苹果自带相册、备忘录等,只需要自然注视和双指捏合,就可以打开你需要的App。

在娱乐体验上更是碾压同类竞品,在发布会现场演示中,苹果展现了Vision Pro“空间计算”的能力。只需要转动头显上的旋钮,就可以将眼前正在播放的电影画面无限放大,让周围的环境与你观看的内容融为一体。想象一下,在高铁上、飞机上、任何一个房间里,只要打开Vision Pro,你就能拥有一个私人影院。苹果还在发布会现场直接拉来了迪士尼CEO Bob Iger,官宣迪士尼内容将登陆Vision Pro。

此外,苹果还格外强调Vision Pro不是一款会将用户和环境隔绝开的设备。当有人靠近你时,头显的前玻璃就会变成透明状态,方便别人看到你的眼睛与你进行交流;当你在进行沉浸式体验时,头显则会呈现为不透明状态,提醒别人你看不到他们。

相比Meta Oculus家族那样纯粹的VR设备,Vision Pro能够无缝连接现实与虚拟世界。无愧为当今最好最贵的头显,至少在观感上,远超市面上所有锚定“元宇宙”的VR设备。

华尔街见闻此前提及,库克非常不喜欢元宇宙这个概念,在整个发布会进行中,苹果没有提到过一次“元宇宙”。

WWDC发布会之后,好事的网友做出了如下对比图:

苹果通过AI技术和十多个摄像头生成的用户数字角色(Digital Persona)

扎克伯格虚拟人

低调务实的AI策略

尽管新推出的混合现实头显设备 Vision Pro 几乎吸引了人们的所有目光,但苹果并没有大谈特谈在AI这方面的技术进展,而是“用事实说话”,告诉人们AI技术落地能实现什么,从而更切实际地改进用户们的体验。

事实上,作为一家产品公司,苹果通常不喜欢谈论“人工智能”本身,而是喜欢“机器学习”这一更具有学术性质的词语,或者仅仅谈论技术落地所能带来的变革。这可以让苹果更专注于研发和展现产品本身,以及如何优化用户体验。

具体来看,在大会上,苹果宣布改进了基于机器学习程序的改进型iPhone自动纠错功能,该功能使用转换语言模型,与支持ChatGPT的技术相同。苹果表示,它甚至会从用户的文本和打字方式中学习,从而优化用户的体验。

此外,苹果还改进了 AirPods Pro 的用户体验,它可以在用户进行对话时自动关闭降噪功能。虽然苹果并没有将这一改进定义为“机器学习”功能,但这是一个很难解决的问题,而解决方案却是基于AI模型的。

另一个苹果很实用的创意是用新数字角色(Digital Persona)功能对用户的脸部和身体进行3D扫描,用户在戴着 Vision Pro 头显与其他人进行视频会议时,就可以虚拟地重现他们的模样;苹果还提到了其他几项利用该公司在神经网络方面进展的新功能,比如识别在PDF中需要填写字段的功能。

头显设备暗藏脑机接口技术?

周二,一位在AR/VR领域工作十年、担任苹果AR神经技术研究员的网友Sterling Crispin发推文,介绍了苹果AR的神经技术研发过程。

据Crispin介绍,他在苹果的工作包括支持Vision Pro的基础性开发,正念体验,还有更多极具挑战的神经技术研究。总的来说,他的很多工作涉及到用户在沉浸式体验中的身体和大脑的数据检测其精神状态。

用户在混合现实或虚拟现实体验中,AI模型试图预测用户是否感到好奇、思维游离、害怕、注意、回忆过去的经历,或其他一些认知状态。

这些可以通过眼球追踪、大脑中的脑电活动、心脏跳动和节律、肌肉活动、血液密度、血压、皮肤传导等测量来推断,使预判行为成为可能。

根据苹果的专利说明和Crispin的介绍,苹果的神经技术可以做到预测用户行为、根据用户状态调整虚拟环境。

最酷的结果是在用户实际点击之前预测他们会点击什么,人们的瞳孔在点击之前往往有反应,原因是人们会期望在点击之后会发生什么。

这时可以通过监测用户的眼睛行为来创造生物反馈,并实时重新设计用户界面,以创造更多预期的瞳孔反应。这是一个通过眼睛实现的粗略“脑机接口”,用户不用接受侵入性的脑部外科手术。

推断认知状态的其他技术,包括以用户可能无法察觉的方式向他们快速闪现视觉或声音,然后测量他们的反应。

另一项专利详细介绍了使用机器学习和来自身体和大脑的信号来预测用户注意力有多集中,或放松,或学习效果如何,然后更新虚拟环境以增强这些状态。

想象一下自适应的沉浸式环境,通过改变背景中看到和听到的东西来帮助你学习,或工作,或放松。

攻略专题

查看更多-

- 《洛克王国手游》雪莉再生机介绍

- 179 2025-02-22

-

- 《洛克王国手游》护主犬介绍

- 104 2025-02-22

-

- 《三国谋定天下》s6开荒最强阵容搭配推荐

- 185 2025-02-22

-

- 《蛋仔派对》小恶魔星紫获取方法

- 126 2025-02-22

-

- 《原神》绮良良圣遗物词条搭配攻略

- 205 2025-02-22

-

- 《原神》琳妮特武器选择推荐

- 148 2025-02-22

热门游戏

查看更多-

- 快听小说 3.2.4

- 新闻阅读 | 83.4 MB

-

- 360漫画破解版全部免费看 1.0.0

- 漫画 | 222.73 MB

-

- 社团学姐在线观看下拉式漫画免费 1.0.0

- 漫画 | 222.73 MB

-

- 樱花漫画免费漫画在线入口页面 1.0.0

- 漫画 | 222.73 MB

-

- 亲子餐厅免费阅读 1.0.0

- 漫画 | 222.73 MB

-