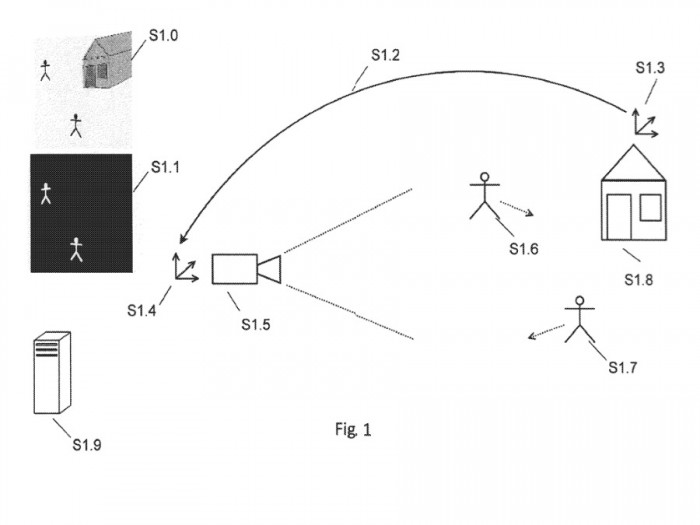

未来的 iPhone 可能会使用热成像或红外成像来补充常规视觉摄像头,使我们在黑暗或繁忙的环境中更容易使用苹果 AR。苹果一项名为 "用于确定至少一个与真实环境一部分相关的属性方法和系统" 的新专利已经曝光。

在这份专利当中,苹果表示,涉及图像分析的计算机视觉方法经常被用于导航、物体识别、3D 重建、相机姿势估计和增强现实应用中,但是在至少有一个真实物体在移动的动态环境中使用相机姿势估计、物体识别、物体跟踪、同步定位和跟踪 (SLAM) 或结构 - 运动 (SfM) 算法时,算法的精度往往会大大降低,尽管在实际算法中采用了强大的优化技术,但还是经常出现跟踪失败。很明显,由此产生的问题是,AR 在试图将虚拟物体定位在真实环境中时,会出错。苹果表示,其实问题还在于更深层次的地方,所以解决方案也必须如此。

这是因为各种这样的计算机视觉算法都假设了一个静态的环境,场景中唯一移动的物体就是摄像头本身,而摄像头的姿势可能会被追踪。这个假设常常被打破,因为在许多场景中,各种移动的物体都可能出现在相机的观察范围内。因此,任何 AR 系统都会拥有关于自身的所有可能的定位细节,它们来自于头显或者头显上的摄像头,但追踪其他一切都很困难。而之所以困难,是由于包括数据处理在内的一系列问题引发。

在目前的技术水平中,存在许多用于检测和分割场景中动态(即移动)物体的算法,然而,这种方法通常计算成本很高,并且依赖于运动分割和 / 或光流技术。苹果的解决方案是用依靠热成像或红外线的摄像头来增强 AR 视觉摄像头,可以使用场景中真实物体的热属性,以提高计算机视觉算法的准确性。另外,热成像的使用意味着苹果 AR 不会那么依赖在光线完全充足的情况下使用。

攻略专题

查看更多-

- 《纳米盒》下载课本点读方法

- 159 2025-03-03

-

- 《纳米盒》更换头像方法

- 203 2025-03-03

-

- 《龙息神寂》不盲者弥希亚技能介绍

- 137 2025-03-03

-

- 《斗战封天》萌新开局攻略及主界面功能介绍

- 207 2025-03-03

-

- 《纳米盒》绑定微信方法

- 114 2025-03-03

-

- 《可口的咖啡》打奶泡方法

- 114 2025-03-03

热门游戏

查看更多-

- 快听小说 3.2.4

- 新闻阅读 | 83.4 MB

-

- 360漫画破解版全部免费看 1.0.0

- 漫画 | 222.73 MB

-

- 社团学姐在线观看下拉式漫画免费 1.0.0

- 漫画 | 222.73 MB

-

- 樱花漫画免费漫画在线入口页面 1.0.0

- 漫画 | 222.73 MB

-

- 亲子餐厅免费阅读 1.0.0

- 漫画 | 222.73 MB

-